创建在线推理服务

在线推理服务是指对每一个推理请求同步给出推理结果的在线服务,AI 智算平台为用户提供在线推理服务实例全生命周期管理,推理实例可在线扩容、缩容,推理实例实时监控,推理日志检索查询等功能,方便用户对各种 AI 业务进行可靠性管理。

用户可在模型广场使用已有的预置模型一键部署模型,也可上传私有模型、使用自定义推理镜像部署模型,从而以较低的资源成本获取高并发且稳定的在线模型服务。

从模型广场创建推理服务

前提条件

已经获取 QingCloud 管理控制台账户和密码。

操作步骤

-

登录 QingCloud 管理控制台。

-

在顶部导航栏,点击产品与服务 > AI 智算平台 > AI 智算平台,进入其总览页面。

-

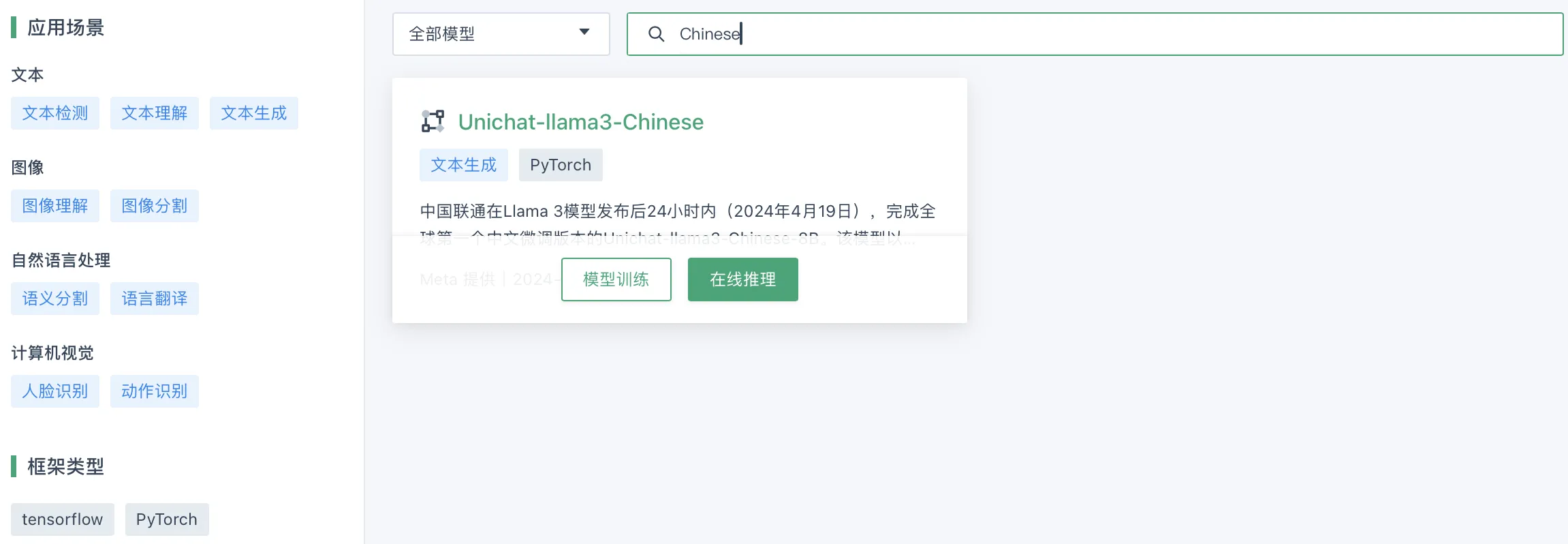

在左侧导航栏,选择模型广场,进入模型广场页面。

-

在模型广场页面,在搜索框内输入关键字段,筛选出待使用的模型,将鼠标悬停在模型上方,点击在线推理。

-

在弹出的创建在线推理服务窗口中,配置各项参数。

参考以下参数说明进行配置。

-

模型名称:用户在模型广场选定的模型名称,系统自动生成。 -

服务名称:选填项,当前在线推理服务的名称,由用户自定义。 -

资源配置:必填项,针对当前模型进行在线推理所需的资源配置,用户可根据实际情况选择相应的资源类型及配置。

-

-

点击创建,进入服务信息页面,等待服务创建完成。

-

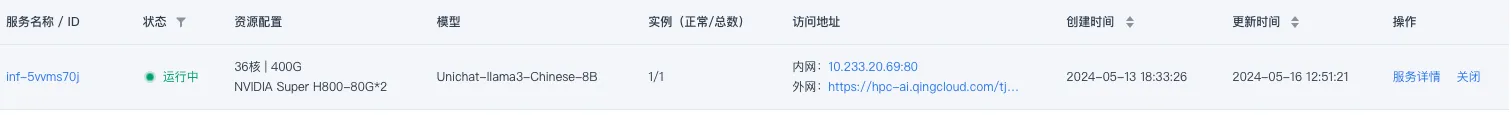

创建成功的服务,其状态应为

运行中,用户即可查看相应模型推理结果。

构建私有模型推理服务

操作步骤

-

登录QingCloud 管理控制台。

-

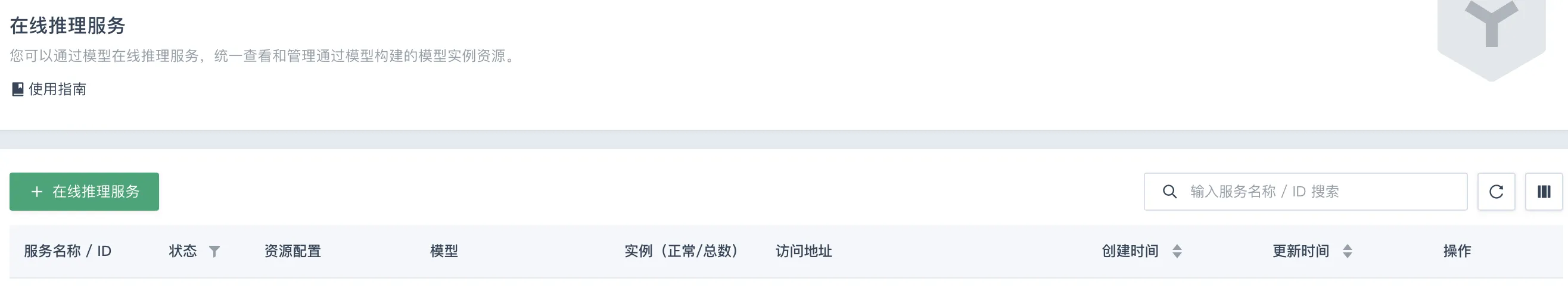

在左侧导航栏,选择推理服务 > 在线推理服务,进入在线推理服务列表页面,点击 + 在线推理服务。

-

在弹出的创建在线推理服务页面中配置各项参数,点击创建即可。

参考以下参数说明进行配置。

参数 说明 服务名称

选填项,当前在线推理服务的名称,由用户自定义。

镜像选择

必填项,支持选择公共镜像、自定义镜像或私有镜像地址。

-

公共镜像:平台内的公共镜像,支持 TensorFlow、Pytorch、Transfeomers 等。

-

自定义镜像:用户保存至自定义镜像仓库内的镜像。

-

镜像地址:公有或用户的私有镜像仓库地址,若设置有密码,则需勾选有密码并输入用户名和密码,获取相应镜像。

模型配置

需配置模型文件和挂载地址。

-

模型文件:必选项,用户提前上传至文件存储下的模型目录,其内须包含所有模型推理所需的模型文件和模型启动代码,根据提示选择相应用户目录下的指定文件夹即可。

-

挂载地址:选填项,模型文件挂载路径,用户自定义即可。推理服务创建过程中,系统会自动将模型文件挂载至实例的相应路径下。

环境变量

选填项,针对当前推理服务,用户自定义配置的环境变量,可根据实际情况添加多个。

第三方依赖

选填项,用于加载镜像中不包含的环境依赖,支持选择第三方列表或 requirements.txt 文件路径。

-

第三方列表:输入格式为 numpy==1.16.4 absl-py==0.11 多个依赖需用空格隔开。

-

requirements.txt 文件路径:根据提示框选择文件所在路径即可,一般在模型文件所在路径下。

启动命令

选填项,根据用户上传的模型文件中启动代码所在路径,填写模型推理的启动命令即可。

网络端口

选填项,Pod 实例启动的网络端口。

资源配置

必填项,针对当前模型进行在线推理所需的资源配置,用户可根据实际情况选择相应的资源类型及配置。

-

-

等待推理服务创建完成,且状态为

运行中表示创建成功,用户即可查看相应模型推理结果。